Le règlement (UE) 2024/1689 du Parlement européen et du Conseil du 13 juin 2024 établissant des règles harmonisées concernant l'intelligence artificielle (AI Act), premier acte législatif sur l'intelligence artificielle (IA), est paru au Journal officiel de l'Union européenne (JOUE) du 12 juillet 2024.

Ce cadre réglementaire de l'IA poursuit les objectifs suivants :

- veiller à ce que les systèmes d’IA mis sur le marché soient sûrs et respectent la législation en vigueur en matière de droits fondamentaux, les valeurs de l’UE, l'État de droit et la durabilité environnementale ;

- promouvoir l'adoption d'une IA axée sur l'humain et digne de confiance ;

- garantir un cadre juridique uniforme afin de faciliter les investissements et l’innovation ;

- renforcer la gouvernance et l’application effective de la législation existante en matière d'exigences de sécurité applicables aux systèmes d’IA et de droits fondamentaux ;

- améliorer le fonctionnement du marché intérieur pour des applications d’IA légales et sûres, et empêcher la fragmentation du marché.

Plus spécifiquement, l'AI Act établit :

- des règles harmonisées concernant la mise sur le marché, la mise en service et l'utilisation de systèmes d'IA dans l'UE ;

- l'interdiction de certaines pratiques ;

- des exigences spécifiques applicables aux systèmes d'IA à haut risque ;

- des règles harmonisées en matière de transparence applicables :

- aux systèmes d'IA destinés à interagir avec des personnes,

- aux systèmes de reconnaissance des émotions et de catégorisation biométrique,

- aux systèmes d'IA générative utilisés pour générer ou manipuler des images ou des contenus audio ou vidéo ;

- des mesures visant à soutenir l'innovation, particulièrement pour les petites et moyennes entreprises (PME).

Cette approche doit tenir compte des résultats bénéfiques sur les plans sociaux et environnementaux que peut apporter l'IA, mais aussi des nouveaux risques ou des conséquences négatives que peut engendrer cette technologie.

La cohérence est assurée avec la Charte des droits fondamentaux de l'UE, mais aussi avec le droit dérivé de l'UE en matière de protection des données, de protection des consommateurs, de non-discrimination et d'égalité entre les femmes et les hommes. Le règlement complète le droit existant en matière de non-discrimination en prévoyant des exigences qui visent à réduire au minimum le risque de discrimination algorithmique, assorties d’obligations concernant les essais, la gestion des risques, la documentation et le contrôle humain tout au long du cycle de vie des systèmes d’IA.

Le règlement sur l'IA sera pleinement applicable à partir du 2 août 2026.

Afin de garantir la sécurité juridique, de faciliter la convergence internationale et une large acceptation, tout en offrant la souplesse nécessaire à la prise en compte des évolutions technologiques rapides de ce domaine, la notion de "système d'IA" est définie par le règlement. Elle est alignée sur les travaux des organisations internationales qui œuvrent dans ce domaine.

Une des caractéristiques essentielle des systèmes d'IA est leur capacité d'inférence, que le règlement définit comme "le processus consistant à générer des sorties telles que des prédictions, du contenu, des recommandations ou des décisions, qui peuvent influencer l’environnement physique ou virtuel, et la capacité des systèmes d’IA à inférer des modèles ou des algorithmes, ou les deux, à partir d’entrées ou de données".

Les techniques qui permettent l'inférence lors de la construction d'un système d'IA comprennent :

- des approches d’apprentissage automatique, qui apprennent à partir des données la manière d’atteindre certains objectifs ;

- des approches fondées sur la logique et les connaissances qui font des inférences à partir des connaissances encodées ou de la représentation symbolique de la tâche à résoudre.

Ces techniques vont au-delà du traitement de données de base en ce que la capacité d'inférence d'un système d'IA lui permet l'apprentissage, le raisonnement ou la modélisation.

Les systèmes d'IA étant conçus pour fonctionner à différents niveaux d'autonomie, ils bénéficient d'un certain degré d'indépendance dans leur action par rapport à une ingérence humaine et de capacités à fonctionner sans intervention humaine.

Qu'est-ce qu'un modèle d'IA à usage général (GPAI) ?

Un système d'IA à but général est défini par le règlement comme un modèle polyvalent pouvant être adapté à un grand nombre d'applications pour lesquelles il n'a pas été spécifiquement conçu. Les principaux modèles d'IA à usage général sont les modèles de langage (LLM) comme GPT d'OpenAI ou Claude de Mistral et les modèles générateurs d'images, par exemple.

Les dispositions relatives aux GPAI sont entrées en application le 2 août 2025. L'AI Act impose notamment aux fournisseurs de GPAI de rédiger une documentation technique et de respecter la directive sur les droits d'auteur.

Le règlement sur l'IA interdit les pratiques suivantes en matière d'intelligence artificielle :

- système d'IA ayant recours à des techniques subliminales au-dessous du seuil de conscience d'une personne pour altérer substantiellement son comportement et de manière à causer un préjudice physique ou psychologique (manipulation du comportement humain pour contourner le libre arbitre) ;

- système d'IA exploitant les éventuelles vulnérabilités dues à l'âge ou au handicap d'un individu pour altérer substantiellement son comportement et de manière à causer un préjudice physique ou psychologique ;

- systèmes d'IA destinés à évaluer ou à établir un classement de la fiabilité de personnes en fonction de leur comportement social ou de caractéristiques personnelles et pouvant entraîner un traitement préjudiciable de personnes, dans certains contextes, injustifié ou disproportionné. L'accord trouvé entre le Parlement et les États membres précise l'interdiction des systèmes de catégorisation biométrique utilisant des caractéristiques sensibles (opinions politiques, religieuses, philosophiques, orientation sexuelle…) et la notation sociale basée sur le comportement social ou les caractéristiques personnelles ;

- systèmes d’IA pour mener des évaluations des risques des personnes physiques visant à évaluer ou à prédire le risque qu’une personne physique commette une infraction pénale, uniquement sur la base du profilage d’une personne physique ou de l’évaluation de ses traits de personnalité ou caractéristiques. Cette interdiction ne s’applique pas aux systèmes d’IA utilisés pour étayer l’évaluation humaine de l’implication d’une personne dans une activité criminelle ;

- systèmes d’IA créant ou développant des bases de données de reconnaissance faciale par le moissonnage non ciblé d’images faciales provenant d’internet ou de la vidéosurveillance ;

- reconnaissance des émotions sur le lieu de travail et les établissements d'enseignement, sauf pour des raisons médicales ou de sécurité ;

- systèmes d'identification biométrique à distance en temps réel dans des espaces accessibles au public à des fins répressives, sauf dans les cas suivants :

- recherche ciblée de victimes potentielles spécifiques de la criminalité (enfants disparus, traite, exploitation sexuelle),

- prévention d'une menace spécifique, substantielle et imminente pour la vie ou la sécurité des personnes ou la prévention d'une attaque terroriste,

- identification, localisation ou poursuite à l'encontre des auteurs ou des suspects de certaines infractions pénales punissables d'une peine d'une durée maximale d'au moins quatre ans.

L'utilisation de systèmes d'identification biométriques à distance en temps réel doit :

- tenir compte de la situation donnant lieu au recours au système et de la gravité ou de l'ampleur du préjudice en l'absence de son utilisation ;

- tenir compte des conséquences sur les droits et libertés de toutes les personnes concernées (gravité, probabilité, ampleur) ;

- être subordonnée à une autorisation préalable octroyée par une autorité judiciaire ou administrative compétente.

L'annexe III du règlement dresse une liste des systèmes d'IA à haut risque. Les eurodéputés ont inclus dans le règlement une analyse d'impact obligatoire sur les droits fondamentaux, également applicable au secteur bancaire et des assurances. Les systèmes d'IA utilisés pour influer sur le résultat d'élections et le comportement des électeurs sont classés à haut risque.

Les citoyens auront le droit de :

- déposer des plaintes concernant les systèmes d'IA ;

- recevoir des explications sur les décisions fondées sur des systèmes d'IA à haut risque ayant une incidence sur leurs droits.

Le non-respect des règles pourra entraîner des amendes pouvant aller jusqu'à 35 millions d'euros ou 7% du CA mondial, en fonction de la taille de l'entreprise et de l'infraction.

Le 4 février 2025, la Commission a publié les lignes directrices sur les pratiques interdites en matière d'IA telles qu'elle sont définies par le règlement. Elles donnent un aperçu des pratiques d'IA jugées inacceptables en raison de leurs risques potentiels pour les valeurs européennes et les droits fondamentaux. Ces lignes directrices fournissent, afin d'aider les parties prenantes à comprendre la législation sur l'IA et de garantir une application cohérente et uniforme dans toute l'UE :

- des interprétations, non contraignantes, sur l'interprétation des interdictions par la Commission ;

- des explications juridiques ;

- des exemples pratiques.

Selon l'article 77 du règlement sur l'IA, chaque État membre doit identifier les autorités ou organismes publics nationaux qui supervisent ou font respecter les obligations au titre du droit de l’Union visant à protéger les droits fondamentaux, y compris le droit à la non-discrimination, en ce qui concerne l’utilisation des systèmes d’IA à haut risque visés à l'annexe III dudit règlement.

Les autorités françaises identifiées sont :

- la Direction générale de la concurrence, de la consommation et de la répression des fraudes (DGCCRF) ;

- la Commission nationale de l’informatique et des libertés (CNIL) ;

- le Défenseur des droits ;

- l'Autorité de régulation de la communication audiovisuelle et numérique (Arcom).

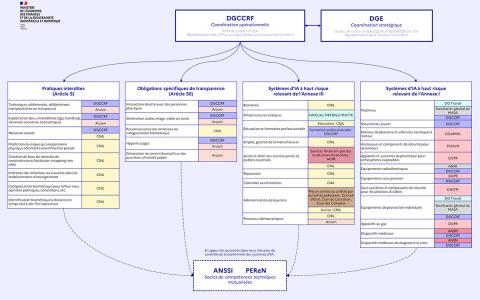

Le contrôle de la bonne mise en œuvre de ce règlement sera assuré en France par plusieurs autorités, en accord avec les orientations proposées par le règlement IA lui-même. En pratique, si une entreprise est déjà régulée sur son secteur, elle s'adressera en très grande majorité à son régulateur habituel pour la mise en œuvre du règlement IA. Le schéma présenté par le gouvernement doit être accepté par le Parlement par le biais d'un projet de loi.

Pratiques interdites

L’Arcom et la DGCCRF seront garantes du respect de l’interdiction de la mise sur le marché, la mise en service ou l’utilisation de systèmes d’IA qui ont recours :

- à des techniques subliminales, délibérément manipulatrices ou trompeuses (art. 5(1a)) ;

- qui exploitent les vulnérabilités liées à l’âge, au handicap ou à la situation sociale ou économique (art. 5(1b)).

Le contrôle du respect de l’interdiction de la mise sur le marché, la mise en service à cette fin spécifique ou l’utilisation de systèmes d’IA destinés à l’évaluation, la classification ou la notation sociale sera assuré par la CNIL et la DGCCRF (art. 5(1c)).

Le contrôle du respect des autres pratiques interdites à l’article 5 du règlement IA sera également assuré par la CNIL :

- police prédictive (art. 5(1d)) ;

- création ou développement de bases de données de reconnaissance faciale par moissonnage non ciblé (art. 5(1e)) ;

- inférence des émotions sur le lieu de travail et dans les établissements d’enseignement (art. 5(1f)) ;

- catégorisation biométrique (art. 5(1g)) ;

- identification biométrique à distance en temps réel à des fins répressives (art. 5(1h)).

Systèmes d'IA à haut risque

Systèmes relevant de l’annexe I

Les autorités de surveillance du marché compétentes pour les produits réglementés par les textes listés à l’annexe I du règlement voient leur périmètre élargi afin de contrôler également l’intégration de l’IA dans ces produits lorsque celle-ci conduit à une classification à haut risque au sens du règlement IA.

De même, les autorités notifiantes compétentes pour les produits réglementés par les textes listés à l’annexe I du règlement voient également leur périmètre élargi, en ce qui concerne la notification des organismes en charge de l’évaluation de la conformité (dits "organismes notifiés").

Systèmes relevant de l’annexe III

Pour les domaines d’usage identifiés à l’annexe III du règlement :

- les Hauts fonctionnaires de défense et de sécurité des ministères de l’économie, des finances et de la souveraineté industrielle et numérique, ainsi que des ministères de l’aménagement du territoire et transition écologique seront responsables du contrôle des systèmes d’IA en matière d’infrastructures critiques (ann. III(2)) ;

- l’Autorité de contrôle prudentiel et de résolution (ACPR) sera responsable des systèmes d’IA destinés à être utilisés pour évaluer la solvabilité des personnes physiques, établir leur note de crédit et évaluer les risques et la tarification en matière d’assurance-vie et d’assurance maladie lorsque l’opérateur de ces systèmes d’IA relève de la compétence de l’Autorité (ann. III(5)) ;

- le Conseil d'État, la Cour de Cassation et la Cour des comptes des systèmes d’IA mis en service ou utilisés par les autorités judiciaires à des fins d’administration de la justice (ann. III(8a)) ;

- la CNIL sera chargée du contrôle des systèmes d’IA en matière d’enseignement et de formation professionnelle avec la DGCCRF (ann. III(3)) , en matière de processus démocratiques avec l’Arcom (ann. III(8b)) , et de tous les autres systèmes d’IA relevant de cette annexe III, notamment en matière de biométrie (ann. III(1)) , d’emploi et de gestion de la main d’œuvre (ann. III(4)) , d’usages répressifs (ann. III(6)) ou de migration, asile et contrôle des frontières (ann. III(7)) .

Le règlement n’appelle pas à la désignation d’autorités notifiantes sur le périmètre des usages identifiés à son annexe III.

Obligations spécifiques de transparence

La CNIL sera chargée du contrôle des obligations applicables aux systèmes de reconnaissance des émotions ou de catégorisation biométrique en vertu de l’article 50(3) du règlement.

La DGCCRF et l’Arcom seront quant à elles chargées du contrôle des systèmes d’IA destinés à interagir directement avec des personnes (art. 50(1)) ; qui génèrent des contenus de synthèse ou qui créent des hypertrucages (art. 50(2,3)), l’ARCOM étant par ailleurs chargée du contrôle des systèmes d’IA qui génèrent ou manipulent des textes publiés dans le but d’informer le public sur des questions d’intérêt public (art. 50(4)).

La création d’un socle de compétences techniques mutualisées

Une mutualisation avancée des compétences et outils techniques en IA et cybersécurité est mise en place par le Pôle d'expertise de la régulation numérique (PEReN) et l'Agence nationale pour la sécurité des systèmes d'information (ANSSI) pour appuyer les autorités dans leurs missions de contrôle de la conformité des systèmes d’IA.

La DGCCRF est chargée de la coordination des autorités de surveillance du marché et jouera à ce titre le rôle de point de contact unique en application de l’article 70.2 du règlement.

La Direction générale des entreprises (DGE) continue d’apporter son soutien à la mise en œuvre de ce texte en tant qu’autorité réglementaire en charge du règlement IA et de son rôle au sein du Comité européen de l’IA, où elle représente la France.

1. DGCCRF - Coordination opérationnelle

Point de contact unique. Représentation des ASM au sous-groupe de coordination du Comité IA

2. DGE - Coordination stratégique. Bureau de liaison unique (SQUALPI, R2019/1020 art. 10)

3. Pratiques interdites (Article 5)

• Techniques subliminales, manipulatrices ou trompeuses : DGCCRF / Arcom

• Exploitation des vulnérabilités (âge, handicap, situation sociale ou économique) : DGCCRF / Arcom

• Notation sociale : DGCCRF / CNIL

• Prédiction du risque qu'une personne physique commette une infraction pénale : CNIL

• Inférence des émotions au travail ou à l’école et dans les établissements d'enseignement : CNIL

• Catégorisation biométrique pour inférer race, opinions politiques, convictions, etc. : CNIL

• Identification biométrique à distance en temps réel à des fins répressives : CNIL

4. Obligations spécifiques de transparence (Article 50)

• Interaction directe avec des personnes physiques : DGCCRF

• Génération audio, image, vidéo ou texte : DGCCRF / Arcom

• Reconnaissance des émotions ou catégorisation biométrique : CNIL

• Hypertrucages : DGCCRF / Arcom

• Génération de texte informatif sur des questions d’intérêt public : Arcom

5. Systèmes d’IA à haut risque – Annexe III

• Biométrie : CNIL

• Infrastructures critiques : HFDS des MEFSIN et MATTE

• Éducation et formation professionnelle, Éducation : CNIL, Formation professionnelle : DGCCRF,

Emploi et gestion de la main-d’œuvre : CNIL

• Accès aux services essentiels (publics et privés), Services financiers : ACPR / CNIL

• Répression : CNIL

• Contrôles aux frontières : CNIL

• Administration de la Justice : mis en service ou utilisés par autorités judiciaires Conseil d’État, Cour de Cassation, Cour des Comptes / Autres : CNIL

• Processus démocratiques : CNIL / Arcom

6. Systèmes d’IA à haut risque – Annexe I

• Machines : DG Travail, Secrétariat général du MASA, DGCCRF

• Sécurité des jouets : DGCCRF

• Bateaux de plaisance et véhicules nautiques à moteur : DGAMPA

• Ascenseurs et composants de sécurité : DGALN

• Appareils et systèmes de protection pour atmosphères explosibles : DGPR

• Équipements radioélectriques : ANFR / DGCCRF

• Équipements sous pression : DGPR / DGCCRF

• Sous-systèmes et composants de sécurité pour installations à câbles : DGITM

• Équipements de protection individuels : DG Travail / Secrétariat général du MASA / DGCCRF

• Appareils au gaz : DGPR

• Dispositifs médicaux : ANSM / DGCCRF

• Dispositifs médicaux de diagnostic in vitro : ANSM / DGCCRF

En appui des autorités dans leurs missions de contrôle de la conformité des systèmes d'IA : Anssi, PEReN (socles de compétences techniques mutualisées)

Sous réserve de l’acceptation par le Parlement dans le cadre d’un projet de loi.

Les systèmes d’intelligence artificielle connaissent une évolution rapide qui nécessite la mise en place de nouvelles formes de contrôle réglementaire et d’un espace sûr pour l’expérimentation. Le règlement doit garantir une innovation responsable et l’intégration de garanties et de mesures d’atténuation des risques appropriées. Pour garantir un cadre juridique propice à l’innovation, les États membres devront mettre en place des "bacs à sable réglementaires" sur l'IA pour faciliter l'innovation sous un contrôle réglementaire strict avant la mise sur le marché ou en service de ces systèmes.

L'objectif est :

- de favoriser l’innovation en créant un environnement contrôlé d’expérimentation au stade du développement afin d'assurer la conformité des systèmes d’IA innovants avec le règlement ;

- de renforcer la sécurité juridique pour les innovateurs ainsi que le contrôle et la compréhension des possibilités, des risques émergents et des conséquences de l’utilisation de l’IA ;

- d’accélérer l’accès aux marchés en supprimant les obstacles pour les PME et les jeunes entreprises.

En 2017, le Conseil européen souligne la nécessité de faire preuve d'un sens de l'urgence face aux tendances émergentes, notamment l'IA [Réunion du Conseil européen (19 octobre 2017) – conclusions].

En 2018, la Commission présente un premier plan coordonné sur l'intelligence artificielle (communication de la Commission). Il s'agit d'un engagement commun visant à renforcer le potentiel européen pour être compétitif à l'échelle mondiale, notamment au travers de stratégies nationales des États membres.

Dans ses conclusions de 2019 sur le plan coordonné, le Conseil de l'UE souligne la nécessité d'assurer le respect intégral des droits des citoyens européens. Le Conseil demande que la législation en vigueur fasse l'objet d'un réexamen [Intelligence artificielle b) Conclusions sur le plan coordonné dans le domaine de l'intelligence artificielle - Adoption].

Le Parlement européen a travaillé sur plusieurs résolutions relatives à l'IA dans divers domaines :

- aspects éthiques [2020/2012(INL)] ;

- régime de responsabilité civile (résolution du Parlement européen du 20 octobre 2020) ;

- droits de propriété intellectuelle (résolution du Parlement européen du 20 octobre 2020) ;

- droit pénal et son utilisation par les autorités policières et judiciaires dans les affaires pénales [2020/2016(INI)] ;

- éducation, culture et audiovisuel [2020/2017(INI)].

Ces textes contiennent des recommandations à destination de la Commission, mais aussi des propositions législatives sur les différents thèmes abordés.

Le 19 février 2020, la Commission publie un Livre blanc sur l'intelligence artificielle qui réaffirme le double objectif européen de promouvoir l'adoption de l'IA et de tenir compte des risques associés à certaines utilisations de cette technologie.

En 2020, le Conseil européen demande à la Commission de "présenter une définition claire et objective des systèmes d'intelligence artificielle à haut risque" [Réunion extraordinaire du Conseil européen (1er et 2 octobre 2020) - conclusions].

Dans des conclusions publiées en octobre 2020, le Conseil de l'UE rappelle que "si les technologies numériques, y compris l'IA, présentent de plus en plus d'opportunités et d'avantages, leur conception, leur développement, leur déploiement et leur utilisation abusive pourraient aussi comporter des risques pour les droits fondamentaux, la démocratie et l'État de droit" [Conclusions de la présidence – La charte des droits fondamentaux dans le contexte de l’intelligence artificielle et du changement numérique].

En avril 2021, la Commission présente des mesures sur l'IA :

- une communication sur la promotion d'une approche européenne ;

- un réexamen du plan coordonné en matière d'intelligence artificielle ;

- une proposition de cadre réglementaire sur l'IA et une analyse d'impact.

Que dit la Cour des comptes européenne ?

Un rapport de la Cour des comptes européenne de mai 2024 analyse l'écosystème européen d'IA :

- les investissements européens dans l'IA n'ont pas suivi le rythme dicté par les leaders mondiaux ;

- les projets dans le domaine de l'IA financés par l'UE ne font pas l'objet d'un suivi systématique ;

- la coordination entre l'UE et les États membres est inefficace, faute d'outils de gouvernance.

Selon le responsable de l'audit, "dans la course à l’IA, il y a fort à parier que le gagnant raflera toute la mise. Si l'UE veut gagner son pari, la Commission européenne et les États membres doivent unir leurs forces de manière plus efficace, accélérer la cadence et libérer le potentiel de l'Union pour réussir cette révolution technologique majeure qui est en cours".

Le 17 mai 2024, le Conseil de l'Europe a adopté la convention-cadre sur l'intelligence artificielle et les droits de l'homme, la démocratie et l'État de droit. Il s'agit d'un traité international, adopté par les ministres des affaires étrangères des 46 pays membres du Conseil de l'Europe.

Cette convention-cadre est le premier texte d'ampleur internationale juridiquement contraignant dans le domaine de l'IA. Ses dispositions devront être transposées dans le droit national des États signataires.

Le texte vise à garantir une IA respectueuse des droits fondamentaux, entre autres face aux risques :

- de pratiques discriminatoires ;

- de remise en cause des processus démocratiques ;

- d'atteinte à la vie privée ;

- d'utilisation de l'IA par certains États à des fins répressives.

La convention-cadre établit des règles relatives au respect des droits fondamentaux à toutes les étapes du cycle de vie de systèmes d'IA.

La convention-cadre est un traité international incluant les États membres de l'UE, mais aussi onze États non membres, dont les États-Unis, le Japon et le Canada. Ce texte est compatible avec le règlement sur l'IA de l'UE qui concerne plus spécifiquement l'Union européenne.

La convention-cadre permet ainsi d'être un texte juridiquement contraignant pour des signataires hors UE parmi les acteurs majeurs dans la recherche et le développement des systèmes d'IA.